2. Inicio y Apagado del Sistema

En la arquitectura x86, la BIOS contiene todo el código requerido para obtener acceso inicial al teclado, pantalla, unidades de disco, de comunicaciones en serie y un número de funciones variadas. Una vez que el sistema completo está en marcha, la mayoría de estos dispositivos habrán mejorado sus capacidades cuando los controladores de dispositivos especializados y completos se cargan y asumen el control.

La BIOS se coloca típicamente en un chip ROM que viene con el equipo (el que a menudo se llama BIOS ROM). Esto asegura que la BIOS estará siempre disponible y no será dañada por fallas en el disco. Esto también hace que sea posible que un equipo arranque.

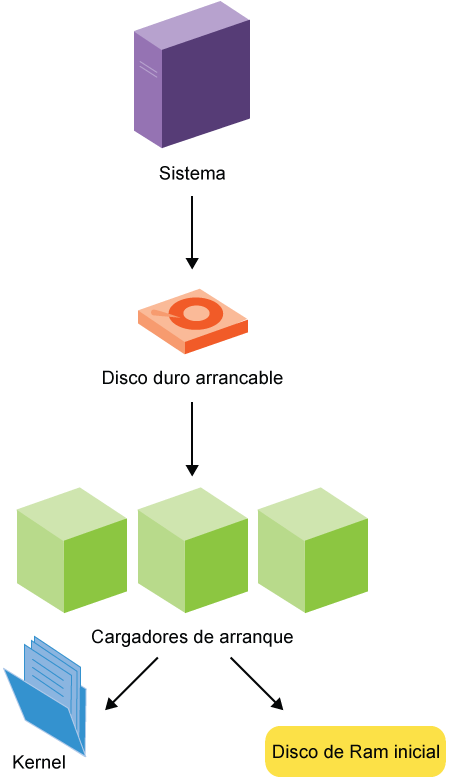

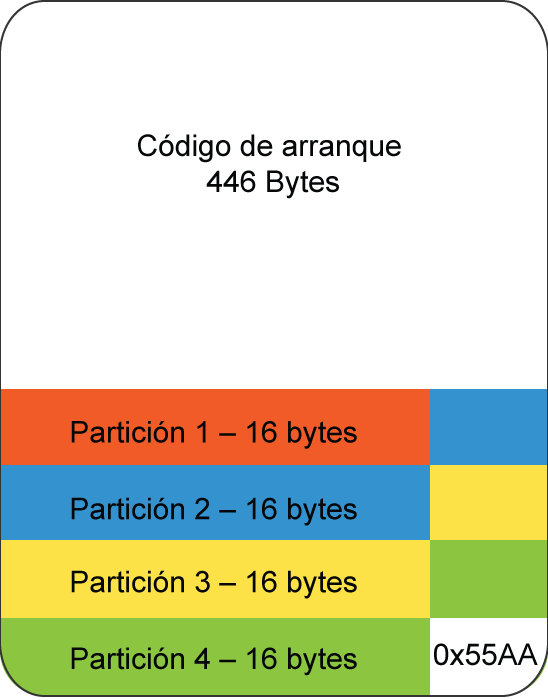

Durante el proceso de arranque, la BIOS carga el gestor de arranque desde el MBR.

Existen diferentes gestores de arranque utilizados en Linux, incluyendo:

- GRUB

- LILO

- efilinux

- Das U-Boot.

Prácticamente todas las distribuciones modernas de Linux (no-embebidas) usan GRUB (GRand Unified Boot Loader). Las características de GRUB incluyen la capacidad de arrancar varios sistemas operativos, tanto en una interfaz gráfica y en otra basada en texto que permite ser usado a través de un cable serial, una potente interfaz de línea de comandos para la configuración interactiva, iniciando desde la red sin disco de arranque y otras características avanzadas.

El cargador de Linux (LILO) es viejo y obsoleto.

efilinux es un gestor de arranque alternativo diseñado específicamente para el mecanismo de UEFI.

Das U-Boot es el cargador más popular para sistemas Linux embebidos; hay algunos otros, entre ellos bareboot. Sin embargo, en realidad no estamos considerando el espacio embebido en este curso.

Más adelante vamos a discutir acerca de donde las distribuciones de Linux cooperan para colocar ciertos tipos de archivos en lugares estándar en el sistema. En particular, los archivos de configuración de todo el sistema se colocan generalmente en /etc y sus subdirectorios, mientras que los específicos del usuario se colocan a menudo en sus directorios personales.

Las distribuciones desarrollaron sus propias reglas sobre exactamente dónde colocar información en /etc. Por ejemplo, todos los sistemas derivados de Red Hat hacen uso extensivo de /etc/sysconfig, mientras que los sistemas basados en Debian han utilizado /etc/default. Curiosamente, RHEL 7 y SUSE usan ambos.

En un sistema RHEL 6:

$ ls -F /etc/sysconfig

atd grub modules samba

auditd htcacheclean netconsole sandbox

authconfig httpd network saslauthd

autofs i18n networking selinux

cbq init network-scripts sendmail

cgconfig ip6tables-config nfs smartmontools

cgred.conf ip6tables-config.rpmnew ntpd snmpd

clock iptables-config ntpdate snmptrapd

collectl iptables-config.rpmnew pluto sshd

console irqbalance prelink sysstat

cpuspeed kdump quota_nld sysstat.ioconf

crond kernel radvd system-config-firewall

dhcpd keyboard raid-check system-config-users

dhcpd6 ksm readahead udev

dhcrelay libvirtd readonly-root vncservers

dhcrelay6 libvirt-guests rhn wpa_supplicant

ebtables-config lm_sensors rngd xinetd

firstboot mcelogd rsyslog

Para ver el contenido de un archivo:

$ cat /etc/sysconfig/network

NETWORKING=yes

HOSTNAME=quad64

GATEWAY=192.168.1.1

lo cual configura algunas variables ambientales usadas por varios scripts de inicio.

Los archivos en este directorio son usados a menudo por el script que controla el servicio asociado en /etc/init.d; por ejemplo, el script /etc/init.d/network incluye la línea con el siguiente archivo:

. /etc/sysconfig/network

el que define estas variables cuando la red se inicia.

En un sistema Ubuntu 14.04:

$ ls -F /etc/default

acpid console-setup grub.ucf-dist locale rsyslog

acpi-support crda halt nfs-common saned

alsa cron im-config nss speech-dispatcher

anacron cups irqbalance ntfs-3g sysstat

apport dbus kdump-tools ntpdate ufw

avahi-daemon devpts kerneloops pulseaudio useradd

bridge-utils grub kexec qemu-kvm whoopsie

brltty grub~ keyboard rcS

bsdmainutils grub.d/ libvirt-bin rsync

El uso de este directorio es similar al /etc/sysconfig de Red Hat:

- Los archivos son utilizados para proveer opciones adicionales al iniciar un servicio.

- Normalmente contienen código para configurar variables de entorno.

Por ejemplo, el archivo /etc/default/useradd establece los valores predeterminados que se utilizan cuando se crean nuevas cuentas de usuario.

shutdown se utiliza para apagar el sistema de forma segura, notificando a todos los usuarios que el sistema va a apagarse y luego lo detiene de manera elegante y no destructiva. Después de que está apagado, el sistema es detenido o reiniciado.

Sin opciones (por ejemplo, shutdown now) el comportamiento por defecto es apagar por completo el sistema. Algunas distribuciones, como Ubuntu, violan esto y van a modo monosuario en vez de apagarse.

Un error común es no especificar un argumento de tiempo (tal como now o algún tiempo real). Esto es requerido.

También existen los comandos heredados reboot, halt y poweroff, los que muchos usuarios veteranos utilizan con frecuencia.

$ sudo shutdown -h +1 "Power Failure imminent"

$ sudo shutdown -h now

$ sudo shutdown -r now

$ sudo shutdown now

Las opciones pueden ser listadas fácilmente por el mensaje de ayuda:

$ shutdown --help

shutdown [OPTIONS...] [TIME] [WALL...]

Shut down the system.

--help Show this help

-H --halt Halt the machine

-P --poweroff Power-off the machine

-r --reboot Reboot the machine

-h Equivalent to --poweroff, overridden by --halt

-k Don't halt/power-off/reboot, just send warnings

--no-wall Don't send wall message before halt/power-off/reboot

-c Cancel a pending shutdown

Organice los pasos básicos de la secuencia de inicio en el orden correcto.

El cargador de arranque es ejecutado.

El kernel Linux y la imagen initrd o initramfs son cargadas en memoria y el núcleo se ejecuta.

El proceso init se inicia.

Módulos adicionales del kernel (incluyendo controladores de dispositivo) se cargan y se inician los servicios del sistema.

Usted debería ser capaz de:

- Explicar el proceso de arranque.

- Identificar varios tipos de cargadores de arranque.

- Describir qué hace la BIOS.

- Identificar los archivos de configuración correspondientes.

- Describir cómo el sistema se apaga y reinicia.

3. GRUB

Un sistema que no puede iniciar es bastante inútil. Los sistemas Linux tienen mucha flexibilidad en la forma de arrancar. Es posible elegir versiones diferentes del kernel u opciones, o incluso diferentes sistemas operativos en escenarios de inicio múltiple. La mayoría de los sistemas no embebidos utiliza el Grand Unified Boot Loader para realizar los primeros pasos de una inicialización exitosa del sistema. GRUB también tiene capacidades interactivas, así como una utilidad de contraseñas seguras.

Al final de este capítulo usted debería ser capaz de:

- Explicar cuál es el rol de GRUB.

- Comprender las diferencias entre las versiones GRUB 1 y GRUB 2.

- Estar familiarizado con las selecciones interactivas que se pueden realizar en el arranque.

- Saber cómo instalar GRUB.

- Explicar cómo se usan y modifican los archivos de configuración que GRUB necesita.

Para cualquier versión, el archivo de configuración principal contiene algunos parámetros globales y luego una sección para cada sistema operativo o núcleo configurado.

Prácticamente todos sistemas basados en x86 de Linux (dejando de lado la esfera de los sistemas embebidos) usan GRUB actualmente (GRand Unified Bootloader) para manejar las primeras fases de arranque del sistema. Otras plataformas pueden tener otros equivalentes, como ELILO, utilizado en sistemas EFI como IA64 (Itanium) y Das U-BOOT utilizado en muchas configuraciones de sistemas embebidos.

Algunas características importantes de GRUB son:

- Sistemas operativos alternativos pueden ser elegidos en el momento del arranque.

- Los kernels alternativos o ramdisk inicial pueden ser elegidos durante el arranque para un determinado sistema operativo.

- Los parámetros de arranque pueden cambiarse fácilmente al arrancar sin tener que editar archivos de configuración, etc. de antemano.

Las distribuciones de Linux más antiguas (por ejemplo, RHEL 6) usan versiones antiguas de GRUB, 1.0 o menor, mientras que las más recientes se basan en GRUB 2. Mientras que los detalles son diferentes entre las versiones, la filosofía básica es la misma.

El archivo de configuración básico de arranque se llama:

/boot/grub/grub.cfg o /boot/grub2/grub.cfg

Este archivo es autogenerado por update-grub (o grub2-mkconfig en RHEL 7), basado en los archivos de configuración en el directorio /etc/grub.d y en /etc/default/grub, y nunca deberían ser editados a mano. Normalmente esas herramientas son ejecutadas desde otros scripts provistos por cada distribución, usados para actualizar o compilar kernels Linux.

El archivo de configuración básico de arranque se llama:

/boot/grub/grub.conf o /boot/grub/menu.lst.

Nuevamente, recomendamos no editar a mano el archivo de configuración. Por ejemplo, en RHEL 5-7 se modifica desde la herramienta grubby. Sin embargo, si usted realiza cambios, serán mantenidos, mientras que para GRUB 2 cualquier cambio directo en grub.cfg se pierde tan pronto como el archivo se genera nuevamente.

Al arranque del sistema, después de las etapas iniciales del POST y BIOS, GRUB se ejecutará y mostrará un menú.

Este puede o no tener gráficos en él (al menos para el fondo de pantalla de splash). El menú contiene una lista de imágenes de arranque de uno o más sistemas operativos o distribuciones de Linux. En GRUB 2 (o, si usas 'chainloading' para conectar múltiples instalaciones de GRUB en el mismo disco, un tema complicado que no trataremos aquí) también pueden haber submenús con aún más opciones.

Usando las flechas arriba y abajo y la tecla Enter, usted puede seleccionar la opción de arranque correcta, o puede esperar durante un periodo de tiempo configurable antes de entrar en la opción predeterminada.

Sin embargo, es posible hacer mucho más. Después de seleccionar una entrada, puede escribir e para editar y luego entrar en una shell interactiva. En esta shell, puede modificar la sección en el archivo de configuración que describe esa opción de arranque particular. Por lo general, esto se hace para modificar la línea de comandos del kernel; por ejemplo, agregando la palabra single al final de la línea de comando hará que el sistema arranque en el modo monousuario con el fin de tomar acciones correctivas. Una vez que el cambio deseado se ha realizado, usted puede presionar la tecla adecuada para iniciar el sistema.

En la parte inferior de la pantalla verá que aparece información sobre las combinaciones de teclas exactas, así que no es necesario memorizarlas.

Tenga en cuenta que cualquier cambio que realice en la configuración no es persistente y se perderá en el próximo inicio. Para realizar cambios permanentes, es necesario modificar los archivos en el sistema, usando las utilidades adecuadas.

También es posible introducir una shell pura, en lugar de editar una sección en particular. Puede ejecutar una serie de comandos diferentes e incluso tratar de reinstalar o reparar GRUB. Si hay problemas serios, como no encontrar un archivo de configuración, GRUB vuelve al modo de línea de comandos y usted podría rescatar el sistema sin tener que recurrir a los medios físicos (DVDs).

La palabra instalación puede tener significados diversos en relación a GRUB:

- Instalar el programa grub y sus herramientas asociadas en sus lugares respectivos. En GRUB 1 hay un solo programa llamado grub, pero en GRUB 2 hay un montón de utilidades con nombres como grub2-* o grub-*; el cómo están empaquetados depende bastante de la distribución.

- Instalar los archivos que GRUB necesita para operar en el momento de arranque, ya sea en /boot/grub o /boot/grub2. Esto es independiente de los archivos que el kernel Linux necesita (vmlinuz-*, initramfs_*), los cuales deberán estar en el directorio /boot también.

- Instalar GRUB como el gestor de arranque en el sistema; generalmente esto se hace en el comienzo de todo el disco duro, pero también puede ser realizado en una partición y acceder a él través de 'chainloading', es decir de un GRUB a otro.

Si no instala GRUB durante la instalación o si necesita volver a instalarlo en algún momento más adelante, el procedimiento exacto para hacerlo depende de la versión de GRUB.

Para la Versión 2, el procedimiento de instalación es tan simple como:

$ sudo grub2-install /dev/sda

Por favor lea la página del manual con cuidado antes de ejecutar un comando como ese; hay muchas opciones y hacer algo mal en GRUB puede hacer que el sistema no arranque. En particular tendrá que indicarle al sistema donde encontrar el directorio /boot y en qué partición reside.

En la versión 1 la herramienta pertinente es grub-install. También es posible ejecutar grub en la línea de comandos, para luego entrar a un programa interactivo. Por ejemplo:

$ sudo grub

> root (hd0,0)

> setup (hd0)

> exit

lo cual debería instalar grub en el primer disco y los archivos de arranque en la primera partición.

En ambas versiones de GRUB, el primer y segundo disco duro es denominado como hd0, el segundo como hd1, etc. Sin embargo, en la versión 1 las particiones comienzan contando desde 0 y en la versión 2 desde 1:

- sda1 es (hd0,1) en GRUB 2, pero (hd0,0) en GRUB 1.

- sdc4 es (hd2,4) en GRUB 2, pero (hd2,3) en GRUB 1.

No hay necesidad de enfatizar que confundirse acerca de esto puede ser muy destructivo. Ambas versiones de GRUB a veces usan la notación de sda# y a veces usan (hd0,#), así que puede ser aún más confuso.

Dentro del archivo de configuración, cada sección tiene que especificar cuál es la partición raíz; esto no es lo mismo que lo que queremos decir cuando hablamos del directorio raíz del sistema. En este contexto significa la partición que contiene el kernel (en el directorio /boot). Por ejemplo, es muy común tener /boot en su partición propia, digamos /dev/sda1. Luego, en GRUB 1 podrá encontrar una sección simple como la siguiente:

title 3.17.3

root (hd0,0)

kernel vmlinuz-3.17.3 ro root=/dev/sda2 quiet

initrd initramfs-3.17.3.img

Sin embargo, si /boot no tiene su propia partición, se vería como lo siguiente:

title 3.17.3

root (hd0,0)

kernel /boot/vmlinuz-3.17.3 ro root=/dev/sda1 quiet

initrd /boot/initramfs-3.17.3.img

También es posible especificar kernel (hd0,0)/vmlinuz .... , y dejar de lado la línea root.

En GRUB 2 la sintaxis es diferente pero obvia; una mirada rápida a /boot/grub2/grub.cfg lo dejará claro.

Nos vamos a concentrar en GRUB 2 porque las versiones anteriores se están volviendo obsoletas rápidamente. Además es esencialmente el mismo en las diversas distribuciones de Linux.

Recuerde que no debería editar grub.cfg directamente. Hay dos lugares en el directorio /etc que deberían requerir atención y se utilizan para reconstruir grub.cfg cuando el sistema se ve alterado con la instalación de kernel nuevos, o cuando se ejecuta de forma manual un programa de actualización (como update-grub).

El primero es /etc/default/grub. En un sistema RHEL 7 luce de la siguiente forma:

$ cat /etc/default/grub

GRUB_TIMEOUT=5

GRUB_DISTRIBUTOR="$(sed 's, release .*$,,g' /etc/system-release)"

GRUB_DEFAULT=saved

GRUB_DISABLE_SUBMENU=true

GRUB_TERMINAL_OUTPUT="console"

GRUB_CMDLINE_LINUX="vconsole.keymap=us crashkernel=auto vconsole.font=latarcyrheb-sun16 rhgb quiet" GRUB_DISABLE_RECOVERY="true"

Red Hat ha abreviado bastante este archivo en comparación con otras distribuciones. Por ejemplo, en un sistema Ubuntu 14.4 se ve de la siguiente forma:

$ cat /etc/default/grub

# If you change this file, run 'update-grub' afterwards to update

# /boot/grub/grub.cfg.

# For full documentation of the options in this file, see:

# info -f grub -n 'Simple configuration'

GRUB_DEFAULT=0

#GRUB_HIDDEN_TIMEOUT=0

GRUB_HIDDEN_TIMEOUT_QUIET=true

GRUB_TIMEOUT=10

GRUB_DISTRIBUTOR='lsb_release -i -s 2> /dev/null || echo Debian'

GRUB_CMDLINE_LINUX_DEFAULT="quiet"

GRUB_CMDLINE_LINUX="find_preseed=/preseed.cfg auto noprompt priority=critical locale=en_US"

# Uncomment to enable BadRAM filtering, modify to suit your needs

# This works with Linux (no patch required) and with any kernel that obtains

# the memory map information from GRUB (GNU Mach, kernel of FreeBSD ...)

#GRUB_BADRAM="0x01234567,0xfefefefe,0x89abcdef,0xefefefef"

# Uncomment to disable graphical terminal (grub-pc only)

#GRUB_TERMINAL=console

# The resolution used on graphical terminal

# note that you can use only modes which your graphic card supports via VBE

# you can see them in real GRUB with the command 'vbeinfo'

#GRUB_GFXMODE=640x480

# Uncomment if you don't want GRUB to pass "root=UUID=xxx" parameter to Linux

#GRUB_DISABLE_LINUX_UUID=true

# Uncomment to disable generation of recovery mode menu entries

#GRUB_DISABLE_RECOVERY="true"

# Uncomment to get a beep at grub start

#GRUB_INIT_TUNE="480 440 1"

El otro directorio que importa es /etc/grub.d:

$ ls -l /etc/grub.d

total 76

-rwxr-xr-x 1 root root 9424 Sep 8 17:35 00_header

-rwxr-xr-x 1 root root 6058 Sep 8 17:35 05_debian_theme

-rwxr-xr-x 1 root root 11608 Sep 8 17:35 10_linux

-rwxr-xr-x 1 root root 10412 Sep 8 17:35 20_linux_xen

-rwxr-xr-x 1 root root 1992 Sep 8 17:35 20_linux_xen

-rwxr-xr-x 1 root root 11692 Sep 8 17:35 30_os-prober

-rwxr-xr-x 1 root root 1416 Sep 8 17:35 30_uefi-firmware

-rwxr-xr-x 1 root root 214 Sep 8 17:35 40_custom

-rwxr-xr-x 1 root root 216 Sep 8 17:35 41_custom

-rw-r--r-- 1 root root 483 Sep 8 17:35 README

donde una vez más estamos mostrando Ubuntu 14.04. Cada uno de estos archivos se ejecutan en orden ascendente cuando se actualiza el archivo de configuración. No los discutiremos aquí debido a que están bien autodocumentados y recomendamos que les eche un vistazo.

Para GRUB 1 cada distribución puede tener algunas peculiaridades, pero básicamente se edita grub.conf directamente o a través de un script como grubby.

¿Cuáles de las siguientes afirmaciones son ciertas?

- Un cargador de arranque como GRUB es necesario para Linux solamente. Otros sistemas operativos, particularmente los propietarios, no necesitan un cargador de arranque para iniciarse.

- GRUB es capaz de iniciar múltiples sistemas operativos como Linux, FreeBSD y Microsoft Windows.

- No es posible utilizar GRUB en modo interactivo cuando el sistema inicia.

- Según cómo está configurado el gestor de arranque puede tener un impacto importante en la seguridad del sistema.

- GRUB puede soportar solamente una configuración para cada sistema operativo. Por lo tanto, no es posible utilizarlo para seleccionar entre los diferentes kernels, opciones del kernel o sistemas de archivos raíz para una sola instalación de Linux.

- El archivo de configuración principal de GRUB 2, grub.cfg, debe ser editado directamente.

Usted debería ser capaz de:

- Explicar cuál es el rol de GRUB.

- Comprender las diferencias entre GRUB 1 y GRUB 2.

- Estar familiarizado con las selecciones interactivas que puede hacer en el arranque.

- Saber cómo instalar GRUB.

- Explicar cómo se usan y modifican los archivos de configuración que GRUB necesita.

4. init: SystemV, Upstart, Systemd

Cuando un sistema Linux se inicia, muchas tareas deben llevarse a cabo de manera cooperativa. Los dispositivos tienen que ser reconocidos e inicializados, los servicios del sistema tienen que ser lanzados, los sistemas de archivos tienen que estar disponibles, procesos de gestión importantes tienen que iniciarse y el sistema debe estar disponible a los usuarios para iniciar sesión. Todo esto debe hacerse en la secuencia correcta y lo más rápidamente posible.

Al final de este capítulo usted debería estar capacitado para:

- Entender la importancia del proceso init.

- Explicar cómo funciona el método tradicional de SysVinit, cómo incorpora los niveles de ejecución y qué sucede en cada uno.

- Saber usar chkconfig y service (y utilidades alternativas) para iniciar y detener servicios o hacerlos persistentes luego del reinicio del sistema.

- Entender por qué surgieron los métodos alternativos Upstart y systemd y cómo funcionan.

- Usar systemctl para configurar y controlar systemd.

/sbin/init (normalmente llamado init) es el primer proceso (o tarea) a nivel de usuario que se ejecuta en el sistema y continúa funcionando hasta que el sistema se apaga. Tradicionalmente ha sido considerado el padre de todos los procesos del usuario, aunque técnicamente eso no es cierto ya que algunos procesos son iniciados directamente por el kernel.

init coordina las etapas posteriores del proceso de arranque, configura todos los aspectos del ambiente e inicia los procesos necesarios para entrar/autenticarse en el sistema. init también trabaja estrechamente con el kernel para limpiar lo necesario a medida en que los procesos terminan.

Tradicionalmente casi todas las distribuciones basan el proceso init en el venerable SysVinit de UNIX. Sin embargo, este esquema fue desarrollado décadas atrás en circunstancias muy diferentes:

- El objetivo eran sistemas multiusuario de tipo mainframe (y no ordenadores personales, portátiles y otros dispositivos).

- El objetivo era un sistema de procesador único.

- El tiempo de inicio (y apagado) no era un asunto importante; era mucho más importante hacer que las cosas funcionaran bien.

El inicio fue visto como un proceso serial, dividido en una serie de etapas secuenciales. Cada etapa requería ser finalizada antes de que la próxima pudiera iniciar. Por lo tanto, el arranque no aprovechó el procesamiento en paralelo que podría hacerse en múltiples procesadores.

En segundo lugar, el apagado/reinicio fue visto como un acontecimiento relativamente raro y exactamente cuánto demoraban no era considerado importante.

Para lidiar con estas limitaciones intrínsecas en SysVinit, se han desarrollado nuevos métodos para controlar el arranque del sistema. Si bien es cierto que existen otros, dos esquemas principales fueron adoptados por distribuidores Empresariales:

- Upstart fue desarrollado por Ubuntu y fue incluido por primera vez en el lanzamiento de la versión 6.10 en el 2006 y pasó a ser utilizado por defecto en el lanzamiento de la versión 9.10, el 2009. También fue adoptado en Fedora 9 (en el 2008) y en RHEL 6 y sus clones, tales como CentOS, Scientific Linux y Oracle Linux. En openSUSE fue ofrecido como una opción desde la versión 11.3. También se ha utilizado en varios dispositivos embebidos y móviles.

- systemd es más reciente y Fedora fue la primera distribución de las principales en adoptarlo en el 2011.

RHEL 7 se basa en systemd y cada distribución principal de Linux lo ha adoptado y usado por defecto, o ha anunciado planes para hacerlo. Los desarrolladores principales de systemd están estrechamente vinculados a la comunidad del kernel de Linux. Incluso Ubuntu ha programado el retiro de Upstart en su favor.

La migración a los nuevos esquemas puede ser complicada debido a que los errores de software y funciones faltantes pueden ser muy incapacitantes, de hecho han habido capas que requieren compatibilidad esencial. Por lo tanto, los métodos y utilidades SysVinit persistirán por mucho tiempo aunque bajo el capó, las cosas son muy diferentes.

La historia de las controversias y todo eso es muy complicado, y personalidades interesantes han asegurado no que toda la discusión es de carácter técnico. En nuestro contexto no veremos a través de esta lente.

En adelante vamos a concentrarnos en SysVinit y systemd con una breve sección sobre Upstart (aunque RHEL 6 y algunas otras distribuciones han estado usando Upstart, éste ha sido completamente oculto detrás de una capa de compatibilidad usando las utilidades SysVinit normales).

Un sistema SysVinit inicia a través de una secuencia de 'runlevels' (niveles de ejecución) que definen diferentes estados del sistema; están numerados del 0 al 6.

El runlevel 0 está reservado para el apagado del sistema, runlevel 1 para el modo monousuario y runlevel 6 para reiniciar el sistema. Los otros runlevels se usan para definir qué servicios están ejecutándose en un sistema normal; según el caso, las distribuciones definen algo de forma diferente. Por ejemplo, en sistemas basados en Red Hat, runlevel 2 se define como un sistema en funcionamiento sin red o X, runlevel 3 incluye soporte de red, y runlevel 5 incluye red y X.

| Runlevel | Significado |

|---|---|

| S,s | Lo mismo que 1 |

| 0 | Apagado del sistema |

| 1 | Modo monousuario |

| 2 | Modo multiusuario, sin NFS, login de texto solamente |

| 3 | Modo multiusuario, con NFS y red, login de texto solamente |

| 4 | No usado |

| 5 | Modo multiusuario, con NFS y red, login gráfico con X |

| 6 | Reinicio |

El runlevel actual pueden ser desplegado simplemente con el comando runlevel, como se muestra aquí:

$ runlevel

N 5

donde el primer caracter es el nivel previo; N significa desconocido.

telinit puede ser usado para cambiar el nivel de ejecución del sistema. Por ejemplo, para ir desde runlevel 3 a runlevel 5, ejecute lo siguiente:

$ sudo /sbin/telinit 5

Cuando el proceso init es iniciado, lo primero que hace es leer /etc/inittab. Históricamente, este archivo ha instruido a init acerca de los scripts que debe ejecutar para llevar al sistema a cada runlevel. Y se ha hecho con una serie de líneas, una para cada runlevel:

id:runlevel(s):action:process

donde:

- id: un identificador único de 1 a 4 caracteres para la entrada.

- runlevel(s): cero o más caracteres individuales o identificadores de dígitos, el que indica en qué nivel de ejecución se realizará la acción.

- action: describe la acción a ser realizada.

- process: especifica el proceso a ser ejecutado.

Sin embargo, en sistemas más recientes como RHEL 6 que enmascaran upstart detrás de una capa de compatibilidad, la única línea descomentada y lo único que se encuentra en este archivo es el runlevel predeterminado con la línea:

id:5:initdefault

Este es el runlevel al cual llegará el sistema una vez que haya terminado de iniciar. Sin embargo, si se especifica otro valor en la línea de comandos del núcleo, init ignora el valor por defecto (esto se hace añadiendo el dígito entero a la línea de comandos del núcleo). El runlevel por defecto es generalmente 5 para un sistema completo, lo cual considera soporte multiusuario, sistema gráfico en red o 3 para un servidor sin una interfaz gráfica.

El método tradicional es que primero se ejecute el script rc.sysinit, el cual realiza numerosas funciones, como iniciar LVM, montar sistemas de archivos, etc. Este script reside en el directorio /etc, pero probablemente lo encontrará en /etc/rc.d con un enlace simbólico a /etc.

A continuación, se ejecuta el script rc (en el mismo directorio) con el runlevel deseado como argumento. Esto hace que el sistema vaya al directorio rc.d/rc[0-6].d y ejecute todos los scripts que están ahí:

$ ls -lF /etc/rc.d/rc5.d

total 0

lrwxrwxrwx. 1 root root 14 Sep 3 10:05 K05pmcd -> ../init.d/pmcd*

lrwxrwxrwx. 1 root root 14 Sep 3 10:05 K05pmie -> ../init.d/pmie*

lrwxrwxrwx. 1 root root 18 Sep 3 10:05 K05pmlogger -> ../init.d/pmlogger*

lrwxrwxrwx. 1 root root 15 Sep 3 10:05 K05pmmgr -> ../init.d/pmmgr*

lrwxrwxrwx. 1 root root 17 Sep 3 10:05 K05pmproxy -> ../init.d/pmproxy*

lrwxrwxrwx. 1 root root 16 Sep 3 10:05 K05pmwebd -> ../init.d/pmwebd*

lrwxrwxrwx 1 root root 37 Sep 6 08:50 K08vmware-USBArbitrator -> /etc/rc.d/init.d/vmware-USBArbitrator*

lrwxrwxrwx. 1 root root 20 Sep 3 03:57 K50netconsole -> ../init.d/netconsole*

lrwxrwxrwx. 1 root root 17 Sep 3 09:39 S10network -> ../init.d/network*

lrwxrwxrwx 1 root root 16 Sep 6 08:50 S19vmware -> ../init.d/vmware*

lrwxrwxrwx. 1 root root 17 Sep 3 04:04 S20iprinit -> ../init.d/iprinit*

lrwxrwxrwx. 1 root root 19 Sep 3 04:04 S20iprupdate -> ../init.d/iprupdate*

lrwxrwxrwx. 1 root root 17 Sep 3 10:05 S21iprdump -> ../init.d/iprdump*

lrwxrwxrwx 1 root root 17 Sep 6 08:51 S25vmamqpd -> ../init.d/vmamqpd*

lrwxrwxrwx 1 root root 37 Sep 6 08:50 S50vmware-USBArbitrator -> /etc/rc.d/init.d/vmware-USBArbitrator*

lrwxrwxrwx. 1 root root 15 Sep 3 03:59 S97rhnsd -> ../init.d/rhnsd*

El script rc.local puede ser usado para iniciar aplicaciones específicas del sistema.

Note lo siguiente:

- Todos los scripts reales están en /etc/init.d: cada directorio de nivel de ejecución solo enlaza a ellos.

- Los nombres de los scripts de inicio comienzan con s.

- Los nombres de los scripts de detención comienzan con k.

La existencia (o falta) de un vínculo simbólico de un script en un directorio de runlevel determina si el script se ejecuta en ese runlevel o no.

El número que le sigue a la K o S en cada nombre de script determina el orden en el cual los scripts son invocados. El nombre del script corresponde también al nombre del servicio.

Controlar qué scripts de inicialización se ejecutan al entrar a cada runlevel consiste en gestionar los enlaces simbólicos. Mientras que es posible administrar estos vínculos de forma manualmente, hay utilidades como chkconfig que están diseñadas para hacer esto de manera consiste y simple.

chkconfig se utiliza para consultar y configurar en qué runlevels van a correr los diferentes servicios del sistema.

No es difícil añadir sus propios servicios y escribir scripts de inicio. Solamente hay que poner el script en /etc/init.d, el cual debe tener ciertas características (¡sólo algunas líneas en el comienzo del archivo!) y luego usar chkconfig --add para habilitarlo o chkconfig --del para desactivar el uso de las instrucciones on y off.

Verifica un servicio en particular para comprobar si está configurado para correr en el runlevel actual:

$ chkconfig some_service

Esto devolverá "verdadero" si el servicio está configurado para ejecutarse, y por el contrario, "falso". Note que aún si el servicio está configurado para correr, podría estar detenido actualmente.

- Ver qué servicios están configurados para correr en cada uno de los runlevels:

$ chkconfig --list [service names] - Configurar un servicio para que se ejecute en el próximo reinicio:

$ sudo chkconfig some_service on - Configurar un servicio para que no se ejecute en el próximo reinicio:

$ chkconfig some_service off - Tenga en cuenta que las operaciones on y off no inciden en el estado actual del servicio para iniciarlo o detenerlo. Esto se realiza de la siguiente forma:

$ sudo service some_service [ stop | start ]

¿Cómo lo hace chkconfig para determinar qué número debería aparecer luego de la S o K en un enlace simbólico? ¿Cómo sabe qué runlevels configurar en on u off y qué estado configurar en los enlaces simbólicos? La información está en los propios scripts, los cuales contienen una línea en la parte de arriba, como la siguiente:

# chkconfig: 2345 10 90

El primer argumento luego de chkconfig: aquí se definen los runlevels en los cuales el servicio va a ejecutarse por defecto. En el ejemplo de arriba con los runlevels 2, 3, 4 y 5.

El segundo y tercer número son los prefijos numéricos en los scripts de inicio y detención; en el caso de arriba inician con S10 y finalizan con K90.

Cada sistema operativo tiene servicios que generalmente arrancan en la inicialización del sistema y a menudo permanecen funcionando hasta el apagado. Tales servicios pueden ser iniciados, detenidos o reiniciados en cualquier momento, lo que generalmente requiere privilegios de root. En un sistema Linux usando o emulando SysVinit, los servicios están en el directorio /etc/init.d.

En sistemas basados en Red Hat es posible ver el estado de un servicio en particular de la siguiente forma:

$ sudo service network status

Configured devices:

lo eth0 eth1 eth2 wlan0

Currently active devices:

lo eth0

$ sudo service vsftpd status

vsftpd (pid 5284) is running...

service tiene diversas opciones, las que varían según el servicio en particular; por ejemplo:

$ sudo service network

Usage: /etc/init.d/network {start|stop|restart|reload|status}

$ sudo service iptables

Usage: /etc/init.d/iptables {start|stop|restart|condrestart|status|panic|save}

Todo servicio se dirige al directorio /etc/init.d y ejecuta el script apropiado en ese directorio con las opciones suministradas.

Es posible ver el estado de todos los servicios en el sistema con:

$ sudo service --status-all

acpid (pid 4170) is running...

anacron (pid 4540) is running...

atd (pid 4553) is running...

....

smartd (pid 4614) is running...

smbd is stopped

......

El iniciar y detener servicios con service es efectivo sólo durante la operación actual del sistema; todos los cambios se pierden al reiniciar. Para configurar que un servicio en particular se active o no durante la inicialización del sistema - en sistemas basados en Red Hat - se utiliza chkconfig como se describió anteriormente.

En sistemas basados en Debian, incluyendo Ubuntu, las utilidades anteriores funcionarán solamente si se han instalado los paquetes sysvinit-utils y chkconfig, como se muestra aquí:

$ sudo apt-get install sysvinit-utils chkconfig

Sin embargo, las versiones recientes de Ubuntu ya no tienen el paquete chkconfig; tendrá que utilizar la utilidad update-rc.d que se describe más abajo.

Como alternativa, puede utilizar los comandos nativos en estos sistemas. Por ejemplo, el equivalente de la utilidad service es:

$ sudo invoke-rc.d cups [ status | start | stop ]

$ sudo status cups

para visualizar o cambiar el estado de cups. El comando status es más reciente y es preferido sobre invoke-rc.d.

Del mismo modo el equivalente de chkconfig sería:

$ sudo update-rc.d cups [ defaults | purge ]

$ sudo sysv-rc-conf cups [ on | off ]

Usted deberá consultar las páginas man para acceder a la documentación completa.

Upstart es manejado por eventos, en lugar de ser un conjunto de procedimientos en forma serial. Las notificaciones de eventos son enviadas al proceso init para ejecutar ciertos comandos en el momento justo después de que han cumplido los requisitos previos. Debido a que Upstart está siendo reemplazado por systemd, no invertiremos mucho tiempo en él ni hacemos ejercicios al respecto.

Los archivos de configuración de upstart son:

/etc/init/rcS.conf

/etc/rc-sysinit.conf

/etc/inittab

/etc/init/rc.conf

/etc/rc[0-6].d

Cuando el kernel inicia el proceso init, éste ejecuta el script rcS.conf. Esto a su vez, hace que rc-sysinit.conf se ejecute.

rc-sysinit.conf realizará una serie de tareas, incluyendo iniciar LVM, montar sistemas de archivos y luego ejecuta todos los scripts para el runlevel por defecto especificado en /etc/inittab.

Esto se logra mediante la ejecución de rc.conf y pasando al runlevel. Los scripts del runlevel levantan los servicios en el sistema.

Finalmente, scripts adicionales como prefdm.conf son ejecutados (para el runlevel 5 solamente).

Como se mencionó anteriormente, /etc/inittab está obsoleto y ahora sólo se utiliza para configurar el runlevel predeterminado mediante la línea initdefault. Otra configuración se realiza mediante Upstart en el directorio /etc/init. En general, Upstart se encontrará en el directorio /etc/event.d.

Por ejemplo, el número de consolas tty activas ahora se establece mediante la variable ACTIVE_CONSOLES en /etc/sysconfig/init, la que es leída por /etc/init/start-ttys.conf. El valor predeterminado es ACTIVE_CONSOLES=/dev/tty [1-6], el cual inicia un proceso getty desde tty1 hasta tty6.

Usando initctl usted puede ver, iniciar y detener procesos casi del mismo modo que lo hace service. La sintaxis es como sigue:

$ initctl options command

donde options puede tener los siguientes valores:

- start: Inicia un proceso

- stop: Detiene un proceso

- restart Reinicia un proceso

- reload Envía la señal HUP a un proceso

- status Consulta el estado de un proceso

- list: Lista los procesos conocidos

- emit Emite un evento.

Es posible encontrar un buen resumen de cómo utilizar initctl y muchas otras características de upstart en http://upstart.ubuntu.com/cookbook.

El sistema de administración central systemd y manejador de sesión para Linux está tomando lugar rápidamente en todas las distribuciones importantes.

systemd es compatible con SysVinit y el concepto de runlevels está soportado a través de 'targets' de nivel de ejecución. El programa telinit es emulado para trabajar con runlevels.

Las características de systemd y del gestor de sesión incluyen lo siguiente:

- Es compatible con los scripts de SysVinit.

- Inicia más rápido que los sistemas anteriores.

- Provee altas capacidades de paralelización.

- Usa socket y activación D-Bus para iniciar servicios.

- Reemplaza scripts de shell scripts con programas.

- Ofrece inicio de demonios sobre demanda.

- Realiza seguimiento de los procesos usando cgroups.

- Soporta la creación de snapshots y restauración del estado del sistema.

- Mantiene puntos de montaje y automontaje.

- Implementa una elaborada lógica de control de servicio basada en dependencia transaccional.

- Puede trabajar como un reemplazo de SysVinit.

En vez de utilizar scripts bash, systemd usa archivos .service. Adicionalmente, systemd clasifica todos los demonios en su propio cgroups del núcleo Linux (grupos de control).

Aunque systemd prefiere utilizar un conjunto de archivos de configuración correspondientes a un estándar nuevo, también puede utilizar archivos de configuración heredados dependiente de cada distribución.

Un ejemplo de un archivo de configuración nuevo sería /etc/hostname, el cual reemplazaría a /etc/sysconfig/network en Red Hat, /etc/HOSTNAME en SUSE y a /etc/hostname (adoptado como estándar) en Debian.

Otros archivos pueden incluir:

- /etc/vconsole.conf: mapa de teclado por defecto y fuente de consola.

- /etc/sysctl.d/*.conf: directorio para los parámetros sysctl del kernel.

- /etc/os-release: archivo de ID de la distribución.

systemctl es la utilidad principal para manejar servicios. La sintaxis básica es la siguiente:

$ systemctl [options] command [name]

Para ver un excelente resumen de cómo pasar desde SysVinit a systemd, consulte la documentación SysVinit to Systemd Cheatsheet en https://fedoraproject.org/wiki/SysVinit_to_Systemd_Cheatsheet.

A continuación puede ver algunos ejemplos de cómo usar systemctl:

- Para ver el estado de todo lo que controla systemd:

$ systemctl - Para ver todos los servicios disponibles:

$ systemctl list-units -t service --all - Para mostrar los servicios activos solamente:

$ systemctl list-units -t service - Para iniciar (activar) una o más unidades:

$ sudo systemctl start foo

$ sudo systemctl start foo.service

$ sudo systemctl start /path/to/foo.service

en donde una unidad puede ser un servicio o un socket. - Para detener (desactivar):

$ sudo systemctl stop foo.service - Para habilitar/deshabilitar un servicio:

$ sudo systemctl enable sshd.service

$ sudo systemctl disable sshd.service

Esto es el equivalente de chkconfig --add/--del y no inicia el servicio.

Nota: algunos comandos systemctl de los mostrados arriba pueden ser ejecutados como usuario normal, sin embargo otros tienen que ser ejecutados como root o con sudo.

| SysVinit Command | Systemd Command | Notas |

|---|---|---|

| service foo start | systemctl start foo.service | Inicia un servicio; no hay efecto luego del reinicio. |

| service foo stop | systemctl stop foo.service | Detiene un servicio; no hay efecto luego del reinicio. |

| service foo restart | systemctl restart foo.service | Detiene el servicio y luego loreinicia. |

| service foo reload | systemctl reload foo.service | Cuando está soportado, recarga los archivos de configuración sin interrumpir las operaciones pendientes. |

| service foo condrestart | systemctl condrestart foo.service | Reinicia si el servicio ya está en ejecución. |

| service foo status | systemctl status foo.service | Indica si un servicio está en ejecución actualmente. |

| ls /etc/rc.d/init.d/ | systemctl list-unit-files --type=service | Lista los servicios que pueden ser iniciados o detenidos. |

| ls /etc/rc.d/init.d/ | ls /lib/systemd/system/*.service | Lista todos los servicios y otras unidades (preferido). |

| chkconfig foo on | systemctl enable foo.service | Habilita en el próximo reinicio u otro evento. |

| chkconfig foo off | systemctl disable foo.service | Deshabilita en el próximo reinicio u otro evento. |

| chkconfig foo | systemctl is-enabled foo.service | Comprueba si un servicio está configurado o no para iniciarse. |

| chkconfig --list | systemctl list-unit-files --type=service | Imprime una tabla listando cada servicio y qué configuración tiene para cada runlevel, ya sea on u off. |

| chkconfig --list | ls /etc/systemd/system/*.wants/ | Comando preferido para la misma operación. |

| chkconfig foo --list | ls /etc/systemd/system/*.wants/foo.service | Lista en qué runlevels este servicio está configurado para estar on u off. |

| chkconfig foo --add | systemctl daemon-reload | Recarga cuando un servicio nuevo se crea o cualquier configuración se modifica. |

Hasta hace poco tiempo atrás, casi todas las distribuciones estaban basadas en SysVinit. Sin embargo hubo problemas que motivaron el desarrollo de systemd. ¿Cuál de las siguientes afirmaciones es correcta?

SysVinit fue diseñado para mainframes, los que tienen requerimientos diferentes a computadores de escritorio, sistemas embebidos y plataformas para dispositivos móviles.

SysVinit fue diseñado para sistemas de núcleos múltiples.

Los tiempos de inicio y apagado no son importantes actualmente.

SysVinit no es confiable.

systemd se orienta a tener un diseño modular y a tener compatibilidad con el SO, objetivos que no se alcanzan con SysVinit.

¿Qué runlevel corresponde a cada ítem de los que se enumeran a continuación?

- Apagado del sistema

- Reinicio

- Modo monousuario

- Modo normal de sólo texto

- Modo normal gráfico

- Laboratorio 4.1 (código fuente: fake_service)

- Laboratorio 4.2

Usted debería ser capaz de:

- Comprender la importancia del proceso init.

- Explicar cómo funciona el método tradicional de SysVinit, cómo incorpora los runlevels y lo que sucede en cada uno de ellos.

- Saber cómo usar chkconfig y service (y utilidades alternativas) para iniciar y detener servicios, o hacerlos persistentes entre reinicios del sistema.

- Entender por qué surgieron los métodos alternativos Upstart y systemd y cómo funcionan.

- Usar systemctl para configurar y controlar systemd.

5. Diseño del Árbol del Sistema de Archivos de Linux

Hay muchos tipos de archivos presentes en un sistema Linux. Se diferencian por su propósito, tamaño, dueño, permisos para ser compartidos. Así mismo, por su permanencia temporal o definitiva en el sistema. Debido a lo anterior, la organización coherente de todo el árbol del sistema de archivos es muy importante, como también su estandarización entre las distribuciones de Linux (en tanto sea posible).

Al final de este capítulo usted debería estar capacitado para:

- Explicar por qué Linux requiere la organización de un gran árbol de sistemas de archivos, y cuáles son las principales consideraciones de cómo hacerlo.

- Conocer el rol desempeñado por el Estándar de Jerarquía del Sistema de Archivos (Filesystem Hierarchy Standard o FHS).

- Describir qué debe estar disponible en el arranque en el directorio raíz (/), y lo que debe estar disponible una vez que el sistema ha iniciado.

- Explicar cada uno de los subdirectorios principales del árbol en términos de propósito y contenido.

Linux, como todos los sistemas operativos basados en UNIX, consiste en un árbol grande de sistemas de archivos. Generalmente es diagramado como un árbol invertido con el directorio raíz / en la parte superior del árbol.

Dentro de este tremendo sistema de archivos lógico pueden haber varios, incluso muchos sistemas de archivos distintos, montados en puntos que corresponden a los subdirectorios. Estos distintos sistemas de archivos suelen estar en particiones diferentes, en diversas cantidades y tipos de dispositivos, incluyendo aquellos que se encuentran en red.

De forma independiente de cómo exactamente las cosas están unidas entre sí, todo se ve como un gran sistema de archivos; las aplicaciones no se preocupan en absoluto de los dispositivos físicos en los cuales residen los archivos.

En el pasado los diferentes sistemas operativos tipo UNIX organizaron este gran árbol de diversas maneras; incluso entre las distribuciones de Linux había muchas diferencias. Esto hizo que tanto el desarrollo de aplicaciones como llevar a cabo tareas de administración en más de un tipo de sistema fuera difícil y a menudo frustrante.

Como consecuencia de lo anterior, el ecosistema Linux ha trabajado arduamente para establecer procedimientos estandarizados para minimizar esos inconvenientes.

Cuando se habla de cómo se organizan los archivos y datos en el gran árbol de directorios, es importante conocer la taxonomía en cuánto a qué tipo de información tiene que ser leída y cuál escrita. En particular, hay dos tipos de diferencias:

- Compartidos vs no-compartidos

Los datos compartibles corresponden a los que se pueden compartir entre diferentes máquinas. Los datos no compartibles son aquellos que son específicos para un determinado host. Por ejemplo, los directorios personales de los usuarios pueden ser compartibles, mientras que los archivos de bloqueo de dispositivos no lo son. - Variable vs. estático

Los archivos estáticos incluyen binarios, bibliotecas, documentación y todo lo que no cambia sin ayuda del administrador de sistemas. Los archivos variables son cualquier cosa que puede cambiar, incluso sin ayuda del administrador de sistemas.

A menudo estas distinciones lógicas están incorporadas como distintos tipos de información que residen en varios directorios, o incluso en particiones y sistemas de archivos.

El Estándar de Jerarquía del Sistema de Archivos (FHS, de Filesystem Hierarchy Standard), administrado inicialmente por el Free Standards Group y ahora por la Linux Foundation, especifica los directorios principales que deben estar presentes y describe sus propósitos. Se puede descargar desde http://www.pathname.com/fhs/.

Al especificar un diseño estándar, el FHS simplifica el tema de la localización de los archivos. Aunque la mayoría de las distribuciones de Linux respetan el FHS, probablemente ninguno de ellos lo sigue exactamente. Por otro lado, la última versión oficial no tiene en cuenta algunos desarrollos nuevos.

A las distribuciones les gusta probar diferentes cosas y eventualmente algunos de los experimentos terminan siendo ampliamente aceptados.

Los distribuidores de Linux pasan mucho tiempo asegurándose de que el diseño de su sistema de archivos es coherente y que evoluciona correctamente en el tiempo.

A continuación se muestra una lista de los directorios principales bajo /:

| Directorio | ¿En FHS? | Propósito |

|---|---|---|

| / | Sí | Directorio principal de la jerarquía completa del sistema de archivos. |

| /bin | Sí | Programas ejecutables esenciales que deben estar disponibles en modo monousuario. |

| /boot | Sí | Archivos necesarios para arrancar el sistema, como el kernel, imagen initrd o initramfs, además de archivos de configuración y programas del gestor de arranque. |

| /dev | Sí | Nodos de dispositivo, usados para interactuar con dispositivos de hardware y software. |

| /etc | Sí | Archivos de configuración del sistema. |

| /home | Sí | Directorios de usuario, incluyendo la configuración personal, archivos, etc. |

| /lib | Sí | Bibliotecas requeridas por binarios ejecutables en /bin y /sbin. |

| /lib64 | No | Bibliotecas de 64-bit requeridas por binarios ejecutables en /bin y /sbin, en sistemas que pueden correr aplicaciones tanto de 32-bit como 64-bit. |

| /media | Sí | Puntos de montaje para dispositivos removibles como CDs, DVDs, pendrives, etc. |

| /mnt | Sí | Sistemas de archivos montados temporalmente. |

| /opt | Sí | Paquetes opcionales de software. |

| /proc | Sí | Sistema de archivos virtual que provee información acerca del sistema y los procesos corriendo en él. Puede ser usado para modificar parámetros del sistema. |

| /sys | No | Sistema de archivos virtual que provee información acerca del sistema y los procesos corriendo en él. Puede ser usado para modificar parámetros del sistema. Es similar a un árbol de dispositivos y es parte del Unified Device Model. |

| /root | Sí | Directorio personal del usuario root. |

| /sbin | Sí | Binarios esenciales del sistema. |

| /srv | Sí | Datos específicos del sitio utilizados por el sistema. Rara vez se utiliza. |

| /tmp | Sí | Archivos temporales; en muchas distribuciones los datos se pierden entre reinicios. Puede ser un ramdisk en memoria. |

| /usr | Sí | Aplicaciones, herramientas y datos multiusuario; en teoría es sólo-lectura. |

| /var | Sí | Datos variables que puedan cambiar durante la operación del sistema. |

Es posible que haya directorios adicionales en el directorio raíz, específicos a cada distribución. Estos podrían incluir /misc, que se puede utilizar para información de diverso tipo y /tftpboot, que se utiliza para el inicio a través de tftp. En caso de haber archivos en ese directorio, están relacionados con el inicio del sistema sin utilizar un disco duro. Note que no viola la FHS el tener otros directorios; sin embargo, la norma es violada cuando se tienen componentes en directorios distintos a los dictados por el estándar.

Mientras que todo el sistema de archivos puede ser visto como un gran árbol, como hemos señalado, pueden haber varias particiones y sistemas de archivos trabajando de forma unida.

La partición y sistema de archivos en el cual el directorio raíz está contenido es bastante especial y a menudo está en una partición dedicada, con otros componentes con directorios como /home, /var, /opt , etc, los cuales son montados posteriormente.

La partición raíz debe contener todos los archivos esenciales necesarios para iniciar el sistema y luego montar el resto de los sistemas de archivos. Por lo tanto necesita utilidades, archivos de configuración, información del cargador de arranque y otros datos esenciales del inicio. Debe estar habilitado para:

- Iniciar el sistema.

- Restaurar el sistema desde copias de seguridad de medios externos, tales como cintas y otros medios extraíbles, o NAS, etc.

- Recuperar y/o reparar el sistema; un administrador experimentado debe tener las herramientas para diagnosticar y reconstruir un sistema dañado.

De acuerdo con el FHS, ninguna aplicación o paquete debería crear nuevos subdirectorios en el directorio raíz.

El directorio /bin es muy importante y éste:

- Contiene programas y scripts ejecutables necesitados tanto por administradores de sistemas y usuarios sin privilegios, que son necesarios cuando todavía no se ha montado ningún otro sistema de archivos, por ejemplo, al iniciar en modo monousuario o en modo de recuperación.

- También puede contener ejecutables que son utilizados indirectamente por scripts.

- No debe contener ningún subdirectorio.

Los programas que deben existir en /bin incluyen:

cat, chgrp, chmod, chown, cp, date, dd, df, dmesg, echo, false, hostname, kill, ln, login, ls, mkdir, mknod, more, mount, mv, ps, pwd, rm, rmdir, sed, sh, stty, su, sync, true, umount, y uname.

También test puede estar ahí. De forma adicional puede incluirse:

csh, ed, tar, cpio, gunzip, zcat, netstat, y ping.

Los comandos binarios que no son considerados esenciales lo suficiente para ir en /bin van en /usr/bin. Solamente los programas requeridos por los usuarios que no son root se colocan en esta categoría.

Nota: Algunas distribuciones muy recientes están abandonando la estrategia de la separación /bin y /usr/bin (como también /sbin y /usr/sbin) y solo tienen un directorio con enlaces simbólicos, preservando así una visión de dos directorios. Consideran como obsoleto el concepto tradicional de permitir la posibilidad de colocar /usr en una partición separada para ser montada después del inicio.

Los archivos esenciales para iniciar el sistema deben estar en el directorio /boot y sus subdirectorios. Los dos archivos absolutamente esenciales son:

- vmlinuz: El kernel Linux comprimido.

- initramfs: El sistema de archivos de RAM inicial, el cual se monta antes de que el sistema real de archivos raíz esté disponible.

Estos archivos tienen nombres largos que dependen de la versión del núcleo, en donde el nombre exacto está en función de la distribución de Linux. Además, en lugar de initramfs, el archivo puede ser llamado initrd, siglas de disco RAM inicial, el cual si bien es cierto corresponde al método antiguo, el nombre se usa en algunas distribuciones todavía.

El contenido exacto de /boot variará según la distribución y el tiempo; en un sistema RHEL 7 tenemos:

$ ls -lF /boot

total 135336

-rw-r--r-- 1 root root 122094 Nov 4 09:20 config-3.10.0-123.13.1.el7.x86_64

-rw-r--r-- 1 root root 81386 Dec 7 12:03 config-3.17.5

-rw-r--r-- 1 root root 81896 Dec 15 07:28 config-3.18.0

-rw-r--r-- 1 root root 81896 Dec 16 15:56 config-3.18.1

drwxr-xr-x. 6 root root 4096 Dec 16 15:57 grub2

-rw-r--r--. 1 root root 40732911 Sep 3 04:07 initramfs-0-rescue-3a0cc7a6d7bb4525815f4d2b4298e611.img

-rw-r--r-- 1 root root 16406996 Dec 10 07:25 initramfs-3.10.0-123.13.1.el7.x86_64.img

-rw-r--r-- 1 root root 13967066 Dec 7 12:03 initramfs-3.17.5.img

-rw-r--r-- 1 root root 13914297 Dec 15 07:28 initramfs-3.18.0.img

-rw-r--r-- 1 root root 13915331 Dec 16 15:56 initramfs-3.18.1.img

-rw-r--r--. 1 root root 865512 Sep 3 04:06 initrd-plymouth.img

-rw-r--r-- 1 root root 228603 Nov 4 09:23 symvers-3.10.0-123.13.1.el7.x86_64.gz

lrwxrwxrwx 1 root root 24 Sep 28 10:18 System.map -> /boot/System.map-3.15.0+

-rw------- 1 root root 2841409 Nov 4 09:20 System.map-3.10.0-123.13.1.el7.x86_64

-rw-r--r-- 1 root root 2875608 Dec 7 12:03 System.map-3.17.5

-rw-r--r-- 1 root root 2891484 Dec 15 07:28 System.map-3.18.0

-rw-r--r-- 1 root root 2891509 Dec 16 15:56 System.map-3.18.1

lrwxrwxrwx 1 root root 21 Sep 28 10:18 vmlinuz -> /boot/vmlinuz-3.15.0+

-rwxr-xr-x. 1 root root 4902000 Sep 3 04:07 vmlinuz-0-rescue-3a0cc7a6d7bb4525815f4d2b4298e611

-rwxr-xr-x 1 root root 4904592 Nov 4 09:20 vmlinuz-3.10.0-123.13.1.el7.x86_64

-rw-r--r-- 1 root root 5363200 Dec 7 12:03 vmlinuz-3.17.5

-rw-r--r-- 1 root root 5404992 Dec 15 07:28 vmlinuz-3.18.0

-rw-r--r-- 1 root root 5405440 Dec 16 15:56 vmlinuz-3.18.1

Hace mucho tiempo estos archivos esenciales se solían poner directamente en /, en vez de usar un directorio /boot por separado, siguiendo las prácticas tradicionales de UNIX. Hoy en día esto se considera obsoleto.

Usted puede haber notado que existen varias versiones del núcleo en /boot, y para cada uno hay cuatro archivos disponibles (la posibilidad de elegir entre los núcleos se hace mediante GRUB en el inicio).

Los otros dos archivos además de vmlinuz y initramfs son:

- config: Es el archivo de configuración utilizado al compilar el kernel. Está presente sólo para referencia y porque puede ser de utilidad al depurar programas.

- System.map: La tabla de símbolos del kernel, la cual es muy útil en la depuración de programas. Entrega las direcciones hexadecimales de todos los símbolos del kernel.

Ninguno de estos archivos es requerido para iniciar o ejecutar el sistema.

Las distribuciones pueden poner otros archivos y directorios en /boot, tales como los sectores de arranque maestros guardados y otros datos no editados a mano.

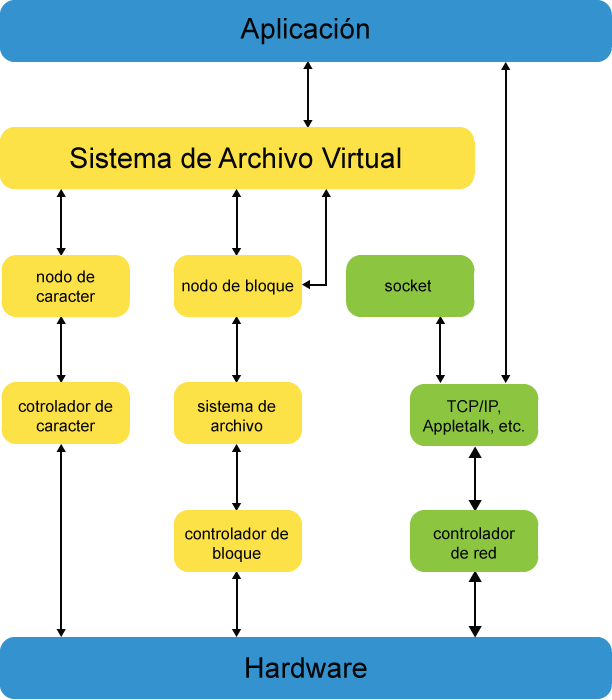

Este directorio contiene archivos de dispositivos especiales (también conocidos como nodos de dispositivo) los cuales representan los dispositivos incorporados o conectados al sistema. Estos archivos especiales son esenciales para que el sistema funcione correctamente.

Dichos archivos de dispositivo representan caracteres (una trama de bytes) y dispositivos de bloque E/S. Los dispositivos de red no tienen nodos de dispositivo en Linux y en cambio son referenciados por su nombre, como eth1 o wlan0.

Listado de /dev

$ cd /dev ; ls -lF

lrwxrwxrwx 1 root root 3 Aug 28 10:12 cdrom1 -> sr0

....

lrwxrwxrwx 1 root root 15 Aug 28 10:12 fitbit -> bus/usb/003/002

....

crw-rw---- 1 root lp 6, 0 Aug 28 10:12 lp0

crw-rw---- 1 root lp 6, 1 Aug 28 10:12 lp1

....

brw-rw---- 1 root disk 8, 4 Aug 28 10:12 sda4

brw-rw---- 1 root disk 8, 5 Aug 28 10:12 sda5

brw-rw---- 1 root disk 8, 6 Aug 28 10:12 sda6

....

brw-rw----+ 1 root cdrom 11, 0 Aug 28 10:12 sr0

Note que los dispositivos de caracter comienzan con una c, los bloques con una b y los enlaces simbólicos con una l (L minúscula).

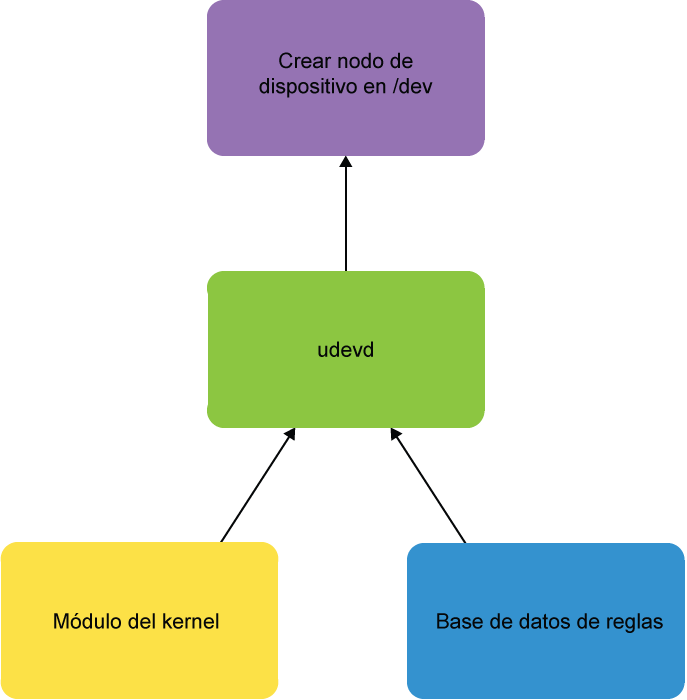

Todas las distribuciones modernas de Linux (no embebidas) utilizan el sistema udev, el cual crea nodos en /dev sólo a medida en que se necesita, lo que sucede cuando se encuentran dispositivos, ya sea al inicio o al conectarlos al sistema (discutiremos udev en una sección posterior).

Si usted fuera a echar un vistazo en el directorio /dev en un sistema de archivos sin montar, lo encontraría vacío; en el inicio se crea y monta un sistema de archivos virtual en /dev, el que luego es populado con nodos de dispositivos, como lo requiere udev. Los sistemas Linux embebidos pueden fijar los nodos de dispositivos y no utilizar udev o alguna alternativa como mdev.

Este directorio contiene los archivos de configuración de la máquina local y algunos scripts de inicio; aquí no debería haber ningún programa ejecutable binario.

Las distribuciones a menudo agregan archivos de configuración y directorios a /etc. Por ejemplo, Red Hat añade un número de directorios adicionales incluyendo /etc/sysconfig, donde se alojan archivos y directorios de configuración del sistema.

Otros subdirectorios importantes incluyen /etc/skel, que contiene archivos de plantilla usados para popular directorios de usuario recién creados. También /etc/init.d, que contiene scripts de inicio y detención cuando se utiliza la inicialización de System V.

Los archivos y directorios que pueden encontrarse aquí incluyen:

csh.login, exports, fstab, ftpusers, gateways, gettydefs, group, host.conf, hosts.allow, hosts.deny, hosts,equiv, hosts.lpd, inetd.conf, inittab, issue, ld.so.conf, motd, mtab, mtools.conf, networks, passwd, printcap, profile, protocols, resolv.conf, rpc, securetty, services, shells, syslog.conf.

En los sistemas Linux los directorios de usuarios están en /home, como /home/coop, /home/alumno, etc. Toda la configuración personal, datos y programas ejecutables se ponen en esta jerarquía de directorios. /home también puede contener subdirectorios para varios grupos o asociaciones de usuarios, como /home/estudiantes, /home/staff, /home/aliens, etc.

En otros sistemas operativos tipo UNIX, existe el concepto del árbol de directorios /home, pero puede ser sutilmente diferente. Por ejemplo, en Solaris los directorios de usuarios se crean en /export/home y luego la utilidad automount los montará en /home. Esto se debe a la situación habitual en que el directorio de los usuarios puede estar en cualquier lugar en una red corporativa, probablemente en un servidor NFS, en donde el directorio de cada usuario se montará automáticamente cuando esté en uso.

Linux también tiene la utilidad automount, pero muchos usuarios no están conscientes de ellos, y en sistemas personales probablemente el concepto de puntos de montaje NFS no aplicará.

Un usuario siempre puede sustituir la variable de ambiente $HOME para su directorio raíz, o la abreviación ~; es decir, los siguientes usos son equivalentes:

$ ls -l $HOME/public_html

$ ls -l ~/public_html

Hay una excepción: el directorio home del usuario root en los sistemas Linux siempre se encuentra en /root. Algunos sistemas UNIX antiguos pueden usar / en cambio, lo que puede causar algún desorden.

Este directorio debe contener sólo las bibliotecas necesarias para ejecutar los binarios en /bin y /sbin. Estas bibliotecas son particularmente importantes para iniciar el sistema y ejecutar comandos en el sistema de archivos raíz.

Los módulos del kernel (a menudo controladores de dispositivo o sistemas de archivos) se encuentran bajo /lib/modules/<kernel-versión-número>.

Los archivos de PAM (Pluggable Authentication Modules) se almacenan en el directorio /lib/security.

Los sistemas que soportan tanto binarios de 32 bits y 64 bits deben mantener ambos tipos de bibliotecas en el sistema. En los sistemas basados en Red Hat hay directorios separados para las bibliotecas de 32 bits (/lib) y 64 bits (/lib64).

Este directorio se usa normalmente para montar sistemas de archivos en medios extraíbles. Estos incluyen CDs, DVDs, unidades USB y disquetes del paleolítico.

Los sistemas Linux modernos montan estos medios de forma dinámica durante la inserción, momento en el cual udev crea directorios bajo /media y luego monta los sistemas de archivos extraíbles allí, con los nombres que se establecen a través de las reglas de udev especificadas en los archivos de configuración. Al desmontar y extraer los medios, los directorios que fueron usados como puntos de montaje en /media desaparecerán.

Si el medio extraíble tiene más de una partición y sistema de archivos, aparecerá más de una entrada en /media. En muchas distribuciones de Linux el administrador de archivos (como Nautilus) se abrirá cuando el medio es montado.

Nota: En algunas distribuciones más recientes (incluyendo SUSE y RHEL 7) los medios extraíbles se montarán en /run/media/[nombre de usuario]/... Vamos a tratar /run al final de este capítulo.

Se dispone de este directorio para que el administrador del sistema pueda montar temporalmente un sistema de archivos en caso de necesitarlo. Se usa comúnmente para sistemas de archivos en red, incluyendo:

- NFS

- Samba

- CIFS

- AFS

Históricamente, /mnt también fue usado para los tipos de archivos que se montan actualmente en /media (o /run/media) en los sistemas modernos.

En términos generales, este directorio no debe ser utilizado por programas de instalación. Una mejor alternativa es otro directorio temporal que no esté siendo usado.

Este directorio está diseñado para paquetes de software que desean mantener la totalidad o gran parte de sus archivos en un lugar aislado en vez de dispersarse por todo el sistema en los directorios compartidos con otros programas.

Por ejemplo, si dolphy_app fuera el nombre de un paquete en /opt, todos sus archivos deben residir en directorios bajo /opt/dolphy_app, incluyendo /opt/dolphy_app/bin para binarios y /opt/dolphy_app/man para las páginas man.

Esto puede hacer que tanto la instalación y desinstalación de software sean relativamente fácil, ya que todo está aislado de forma conveniente en una ubicación predecible y estructurada. También hace que sea más fácil para los administradores de sistemas el determinar la naturaleza de cada archivo asociado a un paquete.

Note, sin embargo, que si uno utiliza sistemas de empaquetamiento como RPM y APT, como veremos más adelante, también es fácil de instalar y desinstalar conservando un claro sentido de las ubicaciones de archivos, sin exhibir tal conducta antisocial con la distribución.

En Linux, el directorio /opt es utilizado a menudo por proveedores de aplicaciones, ya sea con software propietario o aquellos que desean evitar las complicaciones asociadas a los cambios entre distribuciones. Por ejemplo, en RHEL 7 los únicos paquetes se encuentran en esta categoría están en /opt/skype y /opt/google, en donde este último tiene subdirectorios para chrome, earth y talkplugin.

Los directorios /opt/bin, /opt/doc, /opt/include, /opt/info, /opt/lib y /opt/man están reservados para uso del administrador del sistema local. Los paquetes pueden proporcionar archivos que estén vinculados o copiados en estos directorios reservados, pero también deben ser capaces de funcionar sin los programas que están en estos directorios especiales.

Este directorio es el punto de montaje para un seudosistema de archivos, donde toda la información reside sólo en memoria, no en disco. Tal como /dev, el directorio /proc está vacío en un sistema que no está corriendo.

El kernel muestra algunas estructuras de datos importantes a través de las entradas disponibles en /proc. Además, cada proceso activo en el sistema tiene su propio subdirectorio, el que ofrece información detallada sobre el estado del proceso, los recursos que está utilizando y su historia.

Las entradas en /proc a menudo se denominan archivos virtuales y tienen cualidades interesantes. Mientras que la mayoría tienen cero bytes de tamaño, cuando se visualiza su contenido es posible comprobar que pueden tener una gran cantidad de información.

Adicionalmente, la mayoría de los ajustes de hora y fecha en los archivos reflejan la hora y fecha actuales, indicativo del hecho de que están en constante cambio. De hecho, la información de estos archivos se obtiene sólo cuando son visualuzados, no se están actualizando constantemente o periódicamente.

Importantes pseudoarchivos, incluyendo /proc/interrupts, /proc/meminfo, /proc/mounts y /proc/partitions, proporcionan un vistazo del estado actual del hardware del sistema.

Otros archivos como /proc/filesystems y el directorio /proc/sys/, proveen información de configuración del sistema y de las interfaces.

Para propósitos de organización, los archivos que contienen información sobre un tema similar se agrupan en directorios virtuales y subdirectorios. Por ejemplo, /proc/scsi/ contiene información de todos los dispositivos SCSI físicos. De la misma forma, los directorios de procesos contienen información acerca de cada proceso corriendo en el sistema.

A lo largo de este curso examinaremos ampliamente las entradas en /proc, y echaremos un vistazo más detallado en los capítulos siguientes acerca de la configuración del kernel y monitoreo del sistema.

Este directorio es el punto de montaje para el seudosistema de archivos sysfs, donde toda la información reside sólo en memoria, no en disco. Al igual que /dev y /proc, el directorio /sys está vacío en un sistema detenido.

sysfs se utiliza tanto para recopilar información sobre el sistema, como también modificar su comportamiento mientras se ejecuta. En ese sentido se parece a /proc, pero es más nuevo y se ha adherido a normas estrictas acerca de qué tipo de entradas que puede contener. Por ejemplo, casi todos los seudoarchivos en /sys contienen sólo una línea o valor; no existe ninguna de las entradas largas que se pueden encontrar en /proc.

Al igual que con /proc, examinaremos entradas en /sys a lo largo de este curso, lo que será relevante en los próximos capítulos acerca de la configuración del kernel y monitoreo del sistema.

Este directorio (pronunciado "slash-root") es el directorio de inicio para el usuario root.

La cuenta de root que es dueña de este directorio se debe utilizar solamente para las acciones que requieren privilegios de superusuario. Para aquellas acciones que pueden realizarse como un usuario sin privilegios, utilice otra cuenta.

Este directorio contiene los archivos binarios esenciales para arrancar, restaurar, recuperar y/o reparar los binarios en el directorio /bin. También debe tener lo necesario para montar otros sistemas de archivos en /usr, /home y otros lugares de ser necesario, una vez que el sistema de archivos raíz esté en buenas condiciones en el arranque.

Los siguientes programas deberían estar incluidos en este directorio (siempre y cuando sus subsistemas estén instalados):

fdisk, fsck, getty, halt, ifconfig, init, mkfs, mkswap, reboot, route, swapon, swapoff, update.

Nota: como se mencionó anteriormente, algunas distribuciones nuevas están abandonando la estrategia de separar /sbin y /usr/sbin (como también /bin y /usr/bin), y sólo tienen un directorio con enlaces simbólicos, preservando una vista de dos directorios.

Este directorio se utiliza para almacenar archivos temporales, y puede ser accedido por cualquier usuario o aplicación. Sin embargo, no se puede esperar que los archivos en /tmp estén ahí por largo tiempo:

- Algunas distribuciones corren trabajos de cron automatizados, los que generalmente eliminan los archivos de más 10 días, a menos que los scripts de purga hayan sido modificado para excluirlos. Esta es la política de RHEL 6.

- Algunas distribuciones eliminan el contenido de /tmp con cada reinicio del sistema. Esta ha sido la política de Ubuntu.

- Algunas distribuciones modernas utilizan un sistema de archivos virtual, usando el directorio /tmp sólo como un punto de montaje para un disco ram utilizando el sistema de archivos tmpfs. Esta es la política por defecto de los sistemas Fedora recientes. Cuando el sistema se reinicia, toda la información se pierde; ¡/tmp es de hecho temporal!

En este último caso, hay que evitar la creación de archivos de gran tamaño en /tmp, debido a que en realidad va a ocupar espacio en memoria en vez de disco, y es fácil dañar o bloquear el sistema a través del agotamiento de la memoria. Si bien es cierto que la guía para las aplicaciones es evitar poner archivos de gran tamaño en /tmp, hay un gran número de aplicaciones que violan esta política. Incluso si fuera posible ponerlos en otro lugar (tal vez mediante la especificación de una variable de entorno), muchos usuarios no saben cómo configurarlo, y por otro lado, todos los usuarios tienen acceso a /tmp.

Esta política puede ser cancelada en los sistemas utilizando systemd, como en Fedora, a través del siguiente comando:

$ systemctl mask tmp.mount

Luego de lo cual es necesario reiniciar el sistema.

El directorio /usr puede ser visto como una jerarquía secundaria. Se utiliza para los archivos que no son necesarios para el inicio del sistema. De hecho, /usr no necesita estar localizado en la misma partición que el directorio raíz y se puede compartir entre los hosts que utilizan la misma arquitectura de sistema a través de la red.

Los paquetes de software no deberían crear subdirectorios directamente bajo /usr. Podrían existir algunos enlaces simbólicos a otros lugares por razones de compatibilidad.

Este directorio tiene usualmente datos de sólo lectura. Contiene binarios que no son necesarios en modo monousuario. Contiene el directorio /usr/local, donde es posible almacenar binarios locales. Las páginas man se encuentran en /usr/share/man.

| Directorio | Propósito |

|---|---|

| /usr/bin | Binarios y scripts no esenciales, que no se necesitan en modo monousuario. En general corresponden a aplicaciones de usuario, las cuales no son necesarias para iniciar el sistema. |

| /usr/include | Archivos header, usados para compilar aplicaciones. |

| /usr/lib | Bibliotecas para programas en /usr/bin y /usr/sbin. |

| /usr/lib64 | Bibliotecas de 64-bit para programas de 64-bit en /usr/bin y /usr/sbin. |

| /usr/sbin | Binarios no esenciales del sistema, tales como demonios. |

| /usr/share | Datos compartidos, usados por aplicaciones. Generalmente son independientes de la arquitectura. |

| /usr/src | Código fuente, usualmente para el kernel Linux. |

| /usr/X11R6 | Archivos de X Window; generalmente obsoleto. No está presente en la mayoría de las distribuciones modernas de Linux. |

| /usr/local | Datos y programas locales específicos al sistema local. Los subdirectorios incluyen bin, sbin, lib, share, include, etc. |

| Directorio | Propósito |

|---|---|

| /var/ftp | Se usa para la base del servidor ftp. |

| /var/lib | Datos persistentes que son modificados por programas a medida en que son ejecutados. |

| /var/lock | Archivos de bloqueo que se usan para controlar el acceso simultáneo a los recursos. |

| /var/log | Archivos de registro. |

| /var/mail | Buzones de correo de los usuarios. |

| /var/run | Información acerca del sistema en funcionamiento desde el último arranque. |

| /var/spool | Tareas en la cola o esperando a ser procesadas, tales como la cola de impresión. |

| /var/tmp | Archivos temporales para ser preservados luego del reinicio del sistema. A veces se enlaza a /tmp. |

| /var/www | Raíz para la jerarquía de los sitios web. |

Este directorio contiene archivos de datos variables (o volátiles) que cambian frecuentemente durante el funcionamiento del sistema. Estos incluyen:

- Archivos de registro.

- Directorios y archivos de spool para imprimir, colas de correo, etc.

- Archivos de datos administrativos.

- Archivos transitorios y temporales, como contenido del caché.

Obviamente, /var no puede ser montado como un sistema de archivos de sólo lectura.

Por razones de seguridad, a menudo se considera una buena idea montar /var como un sistema de archivos por separado. Además, si el directorio se llena, no debería producir un bloqueo del sistema.

/var/log es donde se encuentran la mayoría de los archivos del registro del sistema. El directorio /var/spool es donde se almacenan los archivos locales para procesos como correo, impresión y trabajos de cron a la espera de ser liberados de la cola.

Un nuevo árbol de directorio montado en /run ha estado en uso desde hace varios años por las principales distribuciones de Linux, y pese a que ha sido propuesto para el FHS, no ha sido aceptado formalmente. Sin embargo es bueno saber acerca de su existencia, ya que muy probablemente se encontrará con él.

El propósito de /run es almacenar archivos transitorios: aquellos que contienen información del tiempo de ejecución (runtime), los cuales probablemente sean escritos tempranamente en el inicio del sistema, y que no requieren ser preservados al reiniciar.

Generalmente /run se implementa como un punto de montaje vacío, con un disco ram tmpfs (tal como /dev/shm) montado en tiempo de ejecución. Por lo tanto, este es un seudosistema de archivos existente sólo en memoria.

Algunos directorios existentes, tal como /var/run y /var/lock, serán enlaces simbólicos a los directorios bajo /run. Otros, dependiendo de cada distribución, pueden apuntar a directorios bajo /run.

Según el Filesystem Hierarchy Standard (FHS), qué directorio de alto nivel (bajo /, como /tmp y no como /tmp/otros) son los más apropiados para:

- archivos de configuración.

- archivos personales.

- archivos del registro del sistemas, como los registro del servidor.

- archivos que son utilizados sólo en el inicio, tales como el kernel e initrd.

- módulos del kernel Linux, los que son extensiones cargables del kernel.

Hay algunos directorios que contienen entradas especiales, las cuales resumen las propiedades del sistema, en vez de mostrar otro tipo de datos almacenados en el disco. Esos pseudo-sistemas de archivos son muy importantes para que el sistema funcione adecuadamente. ¿Cuáles de los siguientes directorios contienen este tipo de datos? Seleccione todos los que apliquen:

/boot

/dev

/etc

/lib

/mnt

/opt

/proc

/sys

/srv

Usted debería ser capaz de:

- Explicar porqué Linux requiere que su árbol de sistemas de archivos esté organizado, y cuáles son las consideraciones más importantes en relación a cómo hacerlo.

- Saber cuál es el rol que juega el Estándar de jerarquía del sistema de archivos (FHS).

- Describir qué debe estar disponible durante el inicio en el directorio raíz (/) , y qué debe estar disponible una vez que el sistema ya se haya iniciado.

- Explicar cada uno de los principales subdirectorios del árbol en términos de propósito y contenido.

6. Servicios del Kernel y Configuración

El kernel del sistema operativo se encuentra en el corazón de todos los sistemas Linux, desde el dispositivo embebido o móvil más pequeño, a la supercomputadora más poderosa. Cabe destacar que el kernel tiene las mismas tareas esenciales en este amplio espectro. Controla el acceso al hardware, la competencia por los recursos entre diferentes aplicaciones y otras tareas, maneja la actividad de E/S, los archivos y almacenamiento de datos, seguridad, redes, etc. Al seleccionar los parámetros de línea de comandos del kernel en el inicio, el sistema puede comportarse de diferentes formas.

Al final de este capítulo usted debería ser capaz de:

- Conocer las principales responsabilidades que el kernel debe cumplir y saber cómo lo hace.

- Explicar qué parámetros pueden ser configurados en la línea de comandos del kernel y cómo hacerlos efectivos, ya sea para un sólo inicio del sistema o de forma persistente.

- Saber en donde encontrar documentación detallada acerca de estos parámetros.

- Saber cómo usar sysctl para configurar parámetros del kernel ya sea una vez que el sistema ha iniciado, o de forma persistente luego del reinicio del sistema.

En rigor, Linux es sólo el kernel del sistema operativo. Este último incluye muchos otros componentes, como bibliotecas y aplicaciones que interactúan con el kernel.